tg-me.com/knowledge_accumulator/140

Last Update:

GPT-4 vs ARC: как оно сейчас и конец ли это?

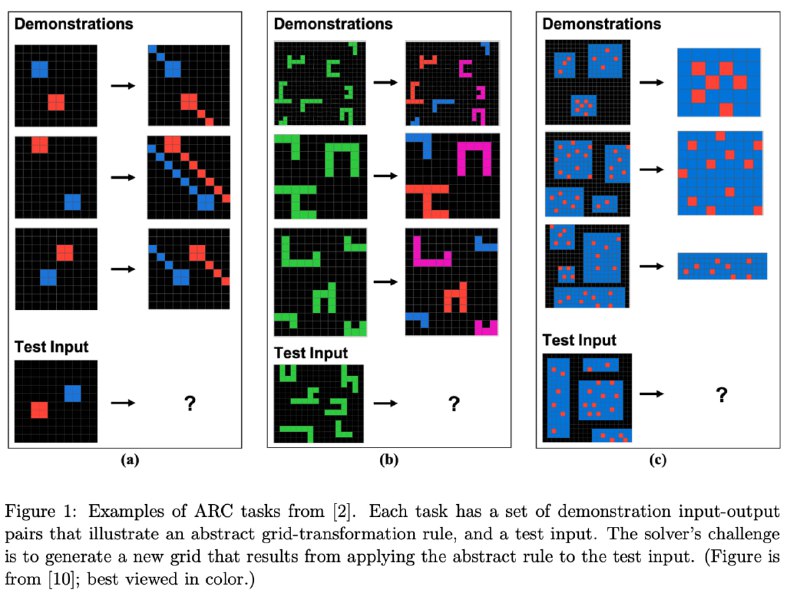

Напомню про существование ARC - бенчмарка системы на способность обучаться задаче по паре примеров. Он задизайнен таким образом, чтобы исключить необходимость понимать человеческие концепты - язык, образы т.д. и проверять только на обучаемость. В этом бенчмарк сильно непохож на GAIA, про который я тоже писал пост. Примеры задач на картинке.

Вы нечасто увидите проверку на нём, поскольку в вопросах обучаемости наши алгоритмы ужасно отстают от человека и просвета в этом вопросе нет. Давайте посмотрим на последние результаты проверки моделей GPT-4 и GPT-4V на нём.

Итак, тестирование проводят на 480 задачках из 16 категорий. Люди решают в среднем 91% задач. Первое место с kaggle-соревнования по ARC набирает около 52% - это по сути полный перебор всевозможных коротких "программ" из 4 преобразований. GPT-4 при новом улучшенном дизайне промпта с примерами решения других задач набирает 33%.

Далее из 480 задач выбирают 48 самых простых, требующих "одношагового" понимания концепта и прогоняют на них ещё и мультимодальную GPT-4V - если до этого задачки преобразовывали в текст, теперь показывают оригинал. Результаты становятся ещё более печальными - 95% человек / 69% GPT-4 / 25% GPT-4V.

Означает ли это бесполезность применения таких моделей? Не совсем. Как уже показали примеры AlphaCode и FunSearch, LLM может использоваться в качестве "генератора идей", с её помощью можно сгененировать много не всегда качественных решений-кандидатов. Но нужен и механизм "валидации" этих идей, чтобы выбрать финальную и её тестировать.

Проблема только в том, что, в отличие от FunSearch, у нас есть всего пара примеров и сгенерированная программа либо полностью неверна, либо полностью верна, что не позволяет проводить никакую оптимизацию решения. А непохожим на AlphaCode этот случай делает то, что у модели нет огромного количества решений подобных задач в обучающих данных, поэтому никакой Pattern matching решений ей недоступен.

@knowledge_accumulator

BY Knowledge Accumulator

Share with your friend now:

tg-me.com/knowledge_accumulator/140